La tua iscrizione ai blog Genesys è stata confermata!

Please add genesys@email.genesys.com to your safe sender list to ensure you receive the weekly blog notifications.

Iscriviti alla nostra newsletter gratuita e ricevi gli aggiornamenti sui blog nella tua casella postale

Non mostrare più questo messaggio.

Immaginiamo che un agente virtuale reindirizzi il problema di fatturazione di un cliente a un sistema di back-end, sottoponga un'anomalia a una valutazione umana e proponga un rimborso prima ancora che il cliente lo abbia richiesto. Con l'AI agentica questo è scenario diventerà presto realtà.

L'intelligenza artificiale (AI) oggi è in prima linea nelle attività delle aziende. Reagisce alle sfumature, si adatta in tempo reale e guida i risultati ricorrendo il meno possibile agli interventi umani. Questi sistemi riconoscono gli obiettivi e adattano il loro comportamento per raggiungerli. Funzionano in modo trasversale a tutti i reparti, su tutti i punti di contatto, persino negli ecosistemi dei partner.

È così che stiano entrando nell'era agentica caratterizzata da una tecnologia sofisticata in grado di interpretare le intenzioni e coordinare le azioni in base a obiettivi definiti. Tuttavia, senza una chiara governance, ogni decisione dell'AI comporta nuovi rischi.

Molti fornitori non esitano a dichiarare "l'autonomia" delle loro soluzioni di AI, ma si tratta di un'affermazione un po' azzardata. Al momento, l'AI non è ancora totalmente autonoma non essendo in grado di elaborare strategie o di funzionare da sola in ambienti complessi, senza l'intervento umano.

Di fatto ci troviamo in una fase di semi autonomia dell'AI che si basa su contesti predefiniti e su una supervisione umana continua.

Non solo confondere “semi-autonomia” e “autonomia” è un errore di fatto, ma è anche fuorviante per l'azienda cliente. Un lancio di prodotto troppo appariscente spesso nasconde problemi di fondo. Le dimostrazioni mettono in mostra la potenza e la velocità del nuovo strumento, ma raramente su soffermano sui temi della trasparenza, del controllo o delle misure etiche. In un mondo in cui l'AI prende migliaia di micro-decisioni al minuto, saltare la governance è come rimuovere i freni da un'auto perché si è aggiornato il motore.

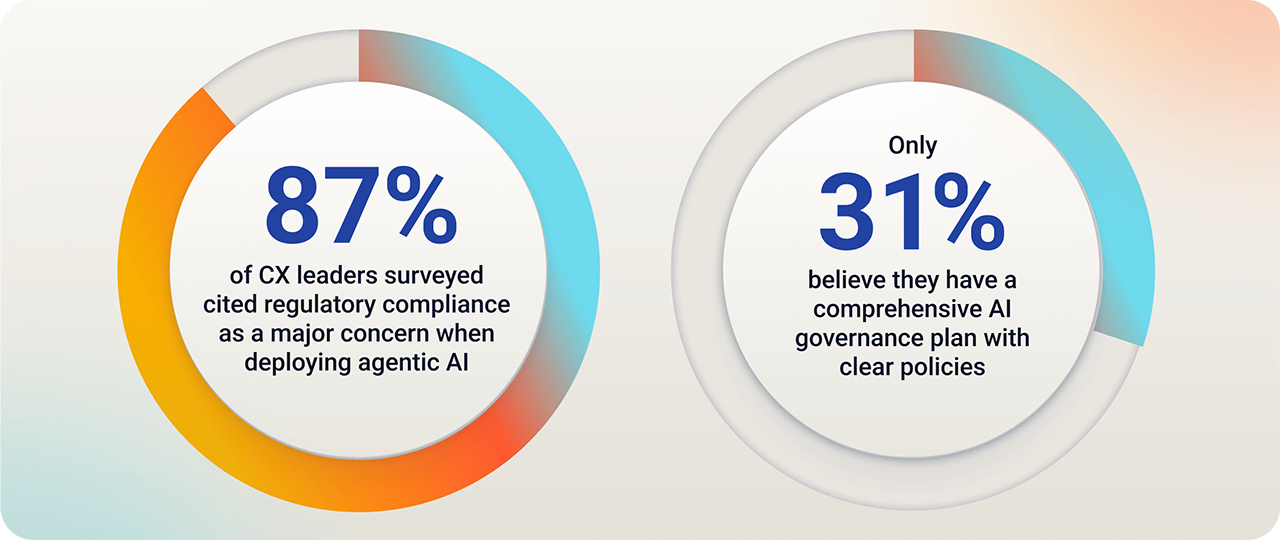

Secondo un nuovo report di Genesysl'87% dei responsabili della CX intervistati ha citato la conformità normativa come una delle principali preoccupazioni nell'implementazione dell'AI agentica. Tuttavia, solo il 31% ritiene di disporre di un piano completo e di politiche chiare per la governance dell'AI. Ancora più allarmante è il fatto che il 28% degli intervistati nelle organizzazioni che non hanno una politica di governance dell'AI ritiene di essere pronto a implementare l'AI agentica.

Questo divario è pericoloso. Se non controllata, l'AI agentica può allontanarsi dalle politiche stabilite, generare informazioni false e minare la fiducia dei clienti in pochi secondi.

Tanto più che non è possibile aggiungere barriere di protezione a posteriori. Per mitigare i rischi dell'AI agentica, la tua governance deve passare da un approccio reattivo di conformità a un'orchestrazione proattiva.

In un momento in cui l'innovazione sta accelerando, molte aziende hanno ancora difficoltà a implementare barriere di protezione. Questa incapacità sta diventando un vero e proprio handicap a livello strategico.

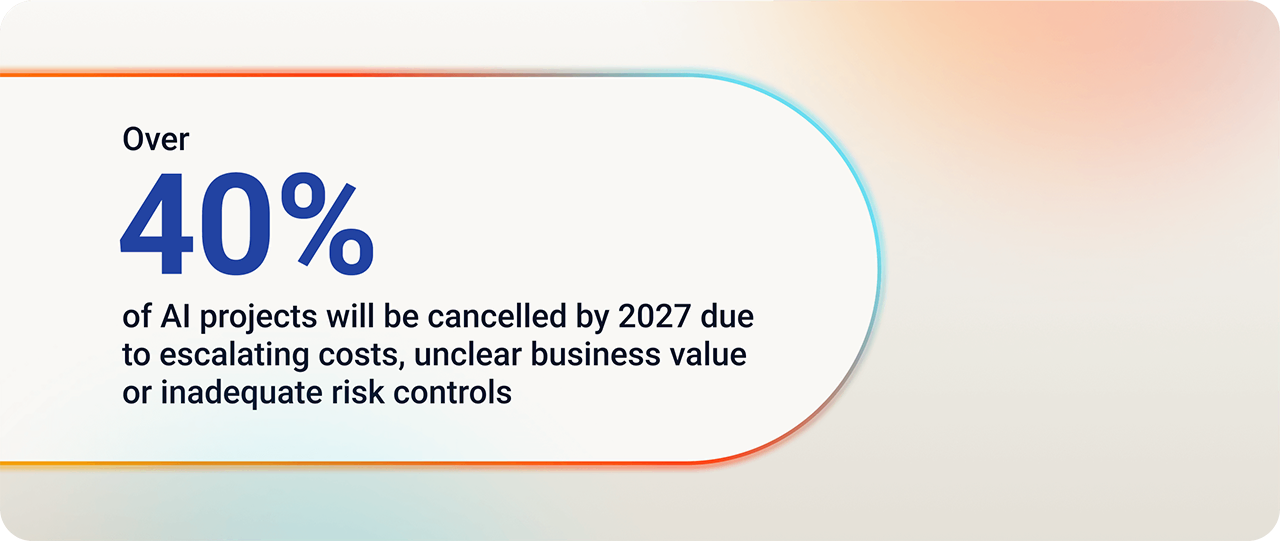

Secondo Gartner®, "oltre il 40% dei progetti di AI sarà annullato entro il 2027 a causa dell'aumento dei costi, di un valore di business poco chiaro o di controlli del rischio inadeguati".

Queste cifre parlano da sole. Quasi la metà delle iniziative di AI potrebbe fallire e questo, in gran parte, a causa della mancanza di governance.

La posta in gioco è quindi chiara. Quando l 'AI diventa profondamente integrata nelle esperienze dei clienti, non è più sufficiente interessarsi solo alle sue capacità intrinseche. È necessario anche delimitarne il campo d'azione e determinare se il suo comportamento è sufficientemente affidabile da poterla utilizzare senza compromettere le relazioni con i clienti, l'integrità del brand e la conformità alle normative.

Non mettere al centro la governance dell'AI significa esporre l'azienda a rischi operativi e danni alla reputazione. Inoltre, limita notevolmente il potenziale e la velocità di evoluzione dell'AI.

L'automazione tradizionale segue alcune regole ben definite. Il bot rileva una richiesta, esegue uno script e produce un risultato. Questo scenario è prevedibile, rigido e utile, ma fino a un certo punto.

I sistemi agentici si comportano in modo diverso. Agiscono per raggiungere degli obiettivi, valutano l'ambiente e regolano le loro azioni di conseguenza. Non è necessario programmare tutti i percorsi possibili, perché l'AI trova il proprio itinerario.

Queste funzionalità aprono un campo di possibilità completamente nuovo. Gli agenti virtualiassomigliano sempre meno ad assistenti digitali e sempre più a collaboratori in grado di risolvere i problemi da soli. Sono in grado di riconoscere le situazioni che richiedono un intervento umano, possono adattare le conversazioni in qualsiasi momento e chiedere chiarimenti invece di fare supposizioni alla cieca. Il software acquisisce più intelligenza ma diventa contemporaneamente più difficile da controllare, e la stessa flessibilità che rende l'AI agentica così potente introduce anche dei rischi.

Ecco perché è fondamentale stabilire un quadro di governance. Fin dal primo giorno, le organizzazioni devono sviluppare sistemi spiegabili, allineati ai propri valori e sufficientemente flessibili, senza sacrificare il controllo.

Senza delle barriere di protezione incorporate, un'AI indipendente può introdurre rischi più velocemente di quanto un'organizzazione possa reagire. I suoi errori non sono più semplici possibilità, ma realtà tangibili per il cliente.

Le aziende devono quindi definire le regole a monte. Cosa è consentito, cosa non lo è e come i sistemi di AI semi-autonomi devono rispondere quando si trovano di fronte a situazioni di incertezza.. Ciò significa anche creare strumenti per monitorare il comportamento e correggere la rotta in tempo reale.

Quando l'AI agisce in base alle proprie scelte e non a script, la governance svolge un ruolo diverso: impone dei vincoli all'AI e la allena a riconoscere ciò che conta per la tua azienda. In questo modo, garantisce che il suo giudizio sia in linea con i tuoi valori e con le aspettative dei clienti.

In Genesys, tutte le soluzioni di AI sono progettate con un occhio di riguardo alla responsabilità. Il nostro impegno a favore della trasparenza e della governance dell'AI è un principio fondamentale che si riflette su ogni prodotto che realizziamo. Incorporiamo barriere di protezione (i guardrails), chiarezza e controllo direttamente nell'architettura, in modo che le aziende non debbano farlo in un secondo momento per raggiungere la conformità.

Dando priorità alla privacy, all'equità e alla sicurezza fin dall'inizio, rendiamo più facile per le organizzazioni utilizzare l'AI con fiducia e responsabilità. Il nostro obiettivo è progettare un'AI affidabile che migliori l'esperienza del cliente e sia in linea con i valori che contano di più.

Questa visione consente di mantenere il controllo sulla tua AI monitorandone il comportamento in tempo reale, segnalando quando le cose vanno male e conservando un registro dettagliato di ogni azione per condurre audit o analisi più approfondite.

I supervisori hanno accesso a funzionalità di controllo in tempo reale con la possibilità di intervenire. Possono sospendere una decisione, correggere una risposta o riprendere il controllo del sistema quando il giudizio umano ha la priorità.

Integrando fiducia, equità e riservatezza nei modelli di AI, l'apprendimento avviene sempre sotto la tua supervisione I cicli di feedback rafforzano i risultati positivi ed eliminano tutto ciò che è inutile. In questo modo, i modelli di AI sanno quando la tecnologia deve intervenire o meno, soprattutto quando compaiono dati regolamentati o si applicano protocolli di escalation. Il risultato è un'AI che non esce dai binari corretti anche quando si trova in una situazione nuova.

Queste misure differiscono dalla tradizionale governance dell'AI. Si tratta di quella che noi chiamiamo una "costituzione agentica" che pone i tuoi valori, le tue politiche e i tuoi obiettivi al centro di ogni decisione presa dall'AI.

Questa è la logica alla base di Genesys Cloud™ AI Studio e della sua funzionalità di punta Genesys Cloud™ AI Guides. Insieme, ti consentono di costruire esperienze di AI più intelligenti e responsabili, preservando i valori del tuo brand.

AI Guides permette alle organizzazioni di creare esperienze agentiche orientate agli obiettivi, dinamiche e responsabili. Agli utenti basta descrivere ciò che l'AI deve realizzare e AI Guides traduce questa visione in comportamenti definiti e tracciabili senza uscire dai tuoi confini etici.

Le funzionalità di Genesys Cloud AI Studio, AI Guides e i Riepiloghi personalizzat delle conversazioni sono ora disponibili.

Genesys definisce la curva della maturità dell'AI in sei livelli di orchestrazione dell'esperienza. Il Livello 1 è caratterizzato da automazione statica, script rigidi, flussi fissi e interventi manuali. Al Livello 2 i sistemi diventano reattivi e attivano azioni, ma sempre seguendo delle regole senza contesto. Crediamo che la maggior parte delle organizzazioni si trovi a questo livello.

Il Livello 3 introduce capacità predittive. Ora l'AI è in grado di anticipare, ma si affida ancora all'uomo per passare dall'intenzione all'azione.

AI Guides ti proietta al Livello 4, quello di intelligenza semi-autonoma. Qui l'AI prende l'iniziativa. Rispetta i tuoi limiti e impara dai risultati per migliorare senza doversi costantemente addestrare. I team passano dalla gestione delle attività alla guida di sistemi intelligenti che aiutano effettivamente ad alleggerire il carico di lavoro.

Il rigoroso design di AI Guides prepara il terreno per il livello successivo: l'orchestrazione agentica universale (Livello 5). A questo livello, gli agenti AI lavorano insieme, condividendo il contesto, riequilibrando le priorità e affinando le strategie in modo indipendente. Il sistema apprende in modo continuo e cooperativo.

Genesys ti offre gli strumenti per passare ai livelli di AI superiori. Mentre gli altri lottano per non restare indietro, tu puoi concentrarti sullo sviluppo di ciò che effettivamente funziona. La strada da seguire è già tracciata Sta a te percorrerla per distinguerti. Il tutto in modo responsabile e con coraggio.

Approfondisci i cinque principi fondamentali che guidano il modo in cui costruiamo, evolviamo e mettiamo a disposizione i sistemi di AI per produrre risultati etici, sicuri e incentrati sull'uomo.

Comunicato stampa di Gartner, Gartner prevede che oltre il 40% dei progetti di AI agentica sarà annullato entro la fine del 2027, 25 giugno 2025

GARTNER è un marchio registrato e marchio di servizio di Gartner, Inc. e/o delle sue affiliate negli Stati Uniti e a livello internazionale e viene utilizzato nel presente documento previa autorizzazione. Tutti i diritti riservati.

Iscriviti alla nostra newsletter gratuita e ricevi gli aggiornamenti sui blog Genesys nella tua casella postale.

Related capabilities: